不適切投稿を世界で4万人が監視 TikTokの「コンテンツモデレーター」の任務とは?:現地で見えたこと(1/2 ページ)

世界中に月間10憶人以上のユーザーを抱えるTikTok。影響力が強いSNSそのものへの不安が高まる中、運営するByteDanceは透明性のアピールに専念する。2024年8月、TikTokのシンガポール本社に各国の記者を招待し、ユーザーの安全を守る取り組みを説明した。

世界150の国と地域で月間10億人以上のユーザーを抱えるTikTok。紹介された商品が拡散して爆発的に売れる「TikTok売れ」といった現象を巻き起こすなど、社会に大きなインパクトを与えるSNSプラットフォームだ。

影響力が増すほどに、外部からは厳しい視線が注がれる。TikTokを運営する中国企業ByteDanceに対し、米国で事業の売却か同国でのTikTok利用禁止を迫る法律が成立したのは記憶に新しい。これは安全保障上のリスクなどが主な理由とされるが、フェイクニュースや人を傷つける悪意あるコンテンツのまん延など、影響力の強いSNSそのものへの不安も日に日に高まっている。

懸念を払拭するため、TikTokはコンテンツの健全性維持の努力とモデレーションの透明性アピールに専念している。2024年8月には、TikTokのシンガポール本社に各国の記者を招待し、TikTokの安全性を高める取り組みを紹介するイベントを開催した。

ユーザーに害をもたらす恐れのあるコンテンツを事前に察知し、削除する「コンテンツモデレーション」(投稿の適正管理)はどのようにして行われているのか。ユーザーの好みを反映した投稿を提案するあまり、似たような動画ばかり表示される「フィルターバブル」を回避するために、どのような対策を取っているのか。同社の取り組みを報告する。

シンガポールのビジネスの中心地、ラッフルズ・プレイス。幾重にも建ち並ぶ高層ビルの中に、ByteDanceのシンガポールオフィスはある。日本を含むアジアの各地域を束ねる主要拠点の一つだ。今回、同社はこのオフィスに、日本、シンガポール、韓国、マレーシア、ベトナム、タイといったアジア各国の記者を招待した。

マーライオンをあしらったネオンライトの壁アートが目を引く。休憩スペースでは卓球に興じる従業員たちの姿も。勢いに乗る企業の、今風のクールなオフィスという印象だ。

コンテンツモデレーターに課された重要な任務とは

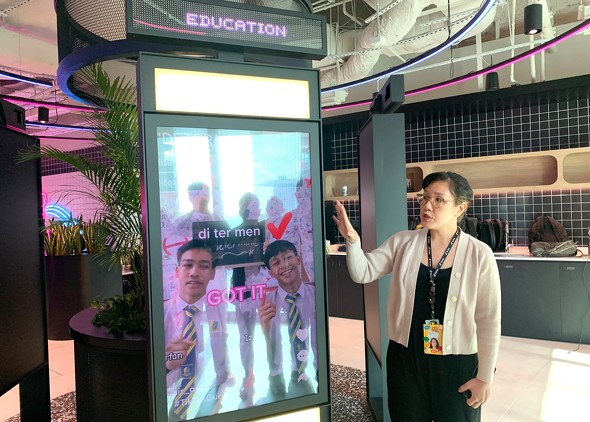

記者団が案内されたのは「透明性説明責任情報公開センター」(Transparency and Accountability Center 、以下TAC)。

TACは、ユーザーの安全を守るためにTikTokが進めるコンテンツモデレーションの取り組みなどを体験的に理解できる施設で、各国のメディア関係者のほか、TikTokに出稿する広告主、政府関係者らが視察に訪れるという。同様の施設は米ロサンゼルスとワシントンDC、アイルランドの首都ダブリンにも設置。シンガポールのTACは2023年に完成した。

「われわれは世界中で1日あたり、約200万件の不適切なコンテンツを検知し、削除しています」(担当者)

コンテンツモデレーションは、ユーザーに害をもたらす恐れのある投稿を、拡散される前に見つけ出して削除する作業だ。多くのユーザーを抱えるSNSプラットフォーマーにとって、大きな責任を伴う業務だ。

TikTokには、こうした業務を担うコンテンツモデレーター(プラットフォームの安心安全に関わるプロフェッショナル)が世界中に4万人以上存在する。独自に策定したコミュニティガイドラインに沿い、犯罪行為やヘイトスピーチ、いじめ、ジェンダーに基づく暴力などポリシーに違反する投稿を削除していく。24時間365日、PCとにらめっこするハードな作業だ。

当然ながら、有人のコンテンツモデレートだけで対処するわけではない。人がチェックする前に、AIによるシステムが最初の監視を担う。投稿の適切性が疑わしければ、有人のチェックに回される。機械と人間の2段階で監視を働かせているわけだ。

例えば、刃物などの危険な道具を手にしている人物が投稿された動画に写っていた場合、機械学習を済ませたシステムが危険性の有無を判断する。

刃物が写る動画全てが削除対象となるわけではない。はさみで紙を切っているような動画であれば、危険性があるとは判断されない。一方で、はさみを人に振りかざしているようなシーンが写る動画であれば、危険性があると判断され弾かれる。投稿された情報の文脈を読み取りながら、弾くか否かが判断される。

TikTokによると、2024年1〜3月の期間に削除された動画の総数は約1億6700万件に上る。これは、公開された動画投稿数の0.9%に相当するという。

また1日あたり削除される約200万件の投稿のうち、77%は人間のモデレーターがチェックするまでもなく、システムによって自動的に弾かれる。「これこそわれわれが取り組む作業スピードの速さを表しています」と担当者は胸を張る。

モデレーターの心的負荷にどう対応?

TACには、コンテンツモデレーターを体験できるスペースがある。記者も実際に体験してみた。

専用のPC画面に、自転車に乗った男が店頭から商品らしきものを奪って逃げ去るような光景が映し出されている。この投稿は、TikTokのコミュニティガイドラインに反しているのか。反しているとすればどのポリシーに反しているのか――。画面上に提示された3つのポリシーのうち、当てはまりそうな「犯罪行為」にチェックを付けて判定ボタンを押す。次のページで、ポリシーに反するポイントが詳しく解説された。

とはいえ、コンテンツモデレーターが遭遇する投稿は、このように判断しやすいものばかりではない。中には白黒がはっきりしないものもある。モデレーターが作業する画面上には、動画を繰り返し確認できるように一時停止・再生のキーフレームが備わるほか、投稿者の情報、フォロワー数、高評価数、シェア数などのデータも併せて表示される。モデレーターはこれらの情報を総合的に確認しながら、投稿が適切かどうかを判断していく。

さらに、地域によって文化的・法的背景もさまざまに異なるため、ある地域でNGとされた投稿が、別の地域では問題ないと判断されるケースもある。世界に4万人存在するTikTokのコンテンツモデレーターは、70以上の言語をカバーし、それぞれの地域の文化的、法的な背景に精通した担当者が、投稿が適切かどうか見極めていく。

「言葉は常に進化し、AIだけでは不適切だと捉えきれない投稿も出てきます。だからこそわれわれは有人のモデレーターを必要とするのです」(担当者)

不適切な投稿のチェックは、心理的な負荷が伴う作業でもある。担当者は「コンテンツモデレーターがしっかりと休息を確保するためのウェルビーイングツールを備え、カウンセラーが現場でサポートできる体制を取っている」と説明。また、コンテンツモデレーターが、毎日、毎時間、同じ種類のコンテンツにさらされないような仕組みを構築していると話した。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ウエルシアのマーケターが語る チラシにはできなくてTikTokだとできること

ウエルシアのマーケターが語る チラシにはできなくてTikTokだとできること

TikTok for Businessが広告主、ビジネスオーナー、広告代理店向けに開催したカンファレンスイベント「ILLUMINATE 2024 Summer」から「ウエルシアが登壇!TikTokを活用して店舗集客とブランド強化を実現した秘策を語る」と題したセッションのハイライトを紹介する。 マーケターは「脱TikTok」を決断すべき? 鍵を握るのはトランプ氏

マーケターは「脱TikTok」を決断すべき? 鍵を握るのはトランプ氏

米国におけるTikTok売却または禁止が議会で可決されたことを受け、このプラットフォームに広告費を投資してきた大手ブランドも軌道修正を余儀なくされている。しかし、ターゲットに効果的にリーチできる有力なプラットフォームから手を引くことは大きな機会損失を意味する。マーケターはどうすればいいのか。 Googleが検知した中国のネット工作活動は2024年第1四半期だけで1万件 「Dragonbridge」の脅威とは?

Googleが検知した中国のネット工作活動は2024年第1四半期だけで1万件 「Dragonbridge」の脅威とは?

Googleのレポートは、2024年の第1四半期における中国の影響活動の規模と範囲を明らかにするとともに、これらの活動が世界中の情報環境に与える影響について警鐘を鳴らしている。今後も、偽情報や影響力工作に対する監視と対応が求められるだろう。 Z世代のGoogle離れはさらに進む 検索はますます「TikTok」「Instagram」依存に

Z世代のGoogle離れはさらに進む 検索はますます「TikTok」「Instagram」依存に

若年層はSNSで検索する傾向が強くなっていることがForbes Advisorの調査で明らかになった。 バーガーキング他の事例に学ぶ「バズるため」の生成AI活用(無料eBook)

バーガーキング他の事例に学ぶ「バズるため」の生成AI活用(無料eBook)

世界のマーケティング先進企業の間では、生成AIをキャンペーンに取り入れる動きが活発化しつつあります。今回の無料eBookのテーマは「マーケティングキャンペーンおける生成AI活用」です。